Minh bạch hóa AI trong kiểm thử: Khi nào “hộp đen” AI trở thành nguy cơ hơn là tiện dụng?

Minh Bạch Hóa AI Trong Kiểm Thử: Khi Nào "Hộp Đen" AI Trở Thành Nguy Cơ?

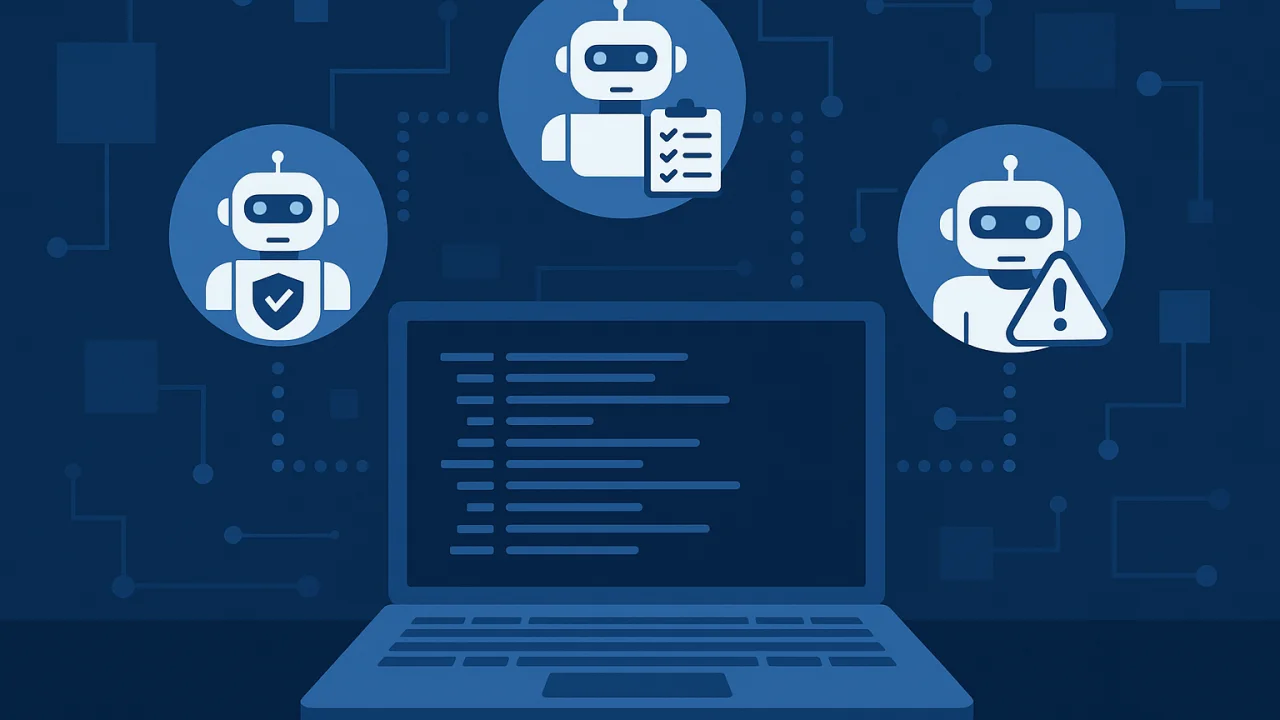

Trong bối cảnh ngành công nghiệp phần mềm ngày càng phụ thuộc vào trí tuệ nhân tạo (AI), việc áp dụng AI trong kiểm thử phần mềm đang trở nên phổ biến. AI giúp tự động hóa các tác vụ phức tạp, tìm ra lỗi nhanh hơn và hiệu quả hơn. Tuy nhiên, đi kèm với những tiện ích đó là một rủi ro lớn: hộp đen AI (AI black box). Vậy, khi nào sự thiếu minh bạch hóa AI này trở thành một mối nguy, và làm thế nào để giải thích các quyết định của nó?

1. "Hộp Đen AI" Là Gì?

"Hộp đen AI" là thuật ngữ chỉ việc không thể hiểu được cách một mô hình AI đưa ra quyết định hoặc dự đoán. Chúng ta chỉ biết được đầu vào và đầu ra, nhưng không thể giải thích được quy trình bên trong. Trong kiểm thử phần mềm, điều này có nghĩa là một công cụ AI có thể báo cáo "Lỗi đã được tìm thấy" nhưng không giải thích được tại sao nó lại coi đó là lỗi.

2. Khi Nào Rủi Ro AI Không Minh Bạch Trở Nên Nghiêm Trọng?

Mối nguy hiểm của hộp đen AI trở nên nghiêm trọng trong các tình huống sau:

- Lỗi nghiêm trọng không được giải thích: Khi AI phát hiện một lỗi nghiêm trọng, đặc biệt là trong các hệ thống quan trọng như y tế, tài chính hoặc hàng không, việc không thể giải thích nguyên nhân gốc rễ của lỗi đó là không thể chấp nhận. Điều này cản trở khả năng của các nhà phát triển trong việc sửa chữa triệt để.

- Thiếu trách nhiệm giải trình: Nếu một lỗi nghiêm trọng xảy ra, ai sẽ chịu trách nhiệm? Khi không có khả năng kiểm thử AI minh bạch, việc xác định nguyên nhân và quy trách nhiệm trở nên vô cùng khó khăn, gây ra những vấn đề pháp lý và đạo đức.

- Mất niềm tin của các bên liên quan: Các nhà phát triển và đội ngũ quản lý cần tin tưởng vào kết quả kiểm thử để đưa ra quyết định. Nếu AI đưa ra một kết quả mà không có bằng chứng hay giải thích, niềm tin sẽ bị xói mòn, khiến các bên phải thực hiện kiểm thử thủ công lại từ đầu.

3. Giải Pháp: Hướng Tới Kiểm Thử AI Minh Bạch

Để giải quyết những rủi ro trên, các công ty cần thực hiện minh bạch hóa AI trong quy trình kiểm thử. Điều này không có nghĩa là phải hiểu từng dòng code của AI, mà là tạo ra các cơ chế để giải thích AI trong kiểm thử một cách rõ ràng:

- Báo cáo chi tiết: AI cần cung cấp báo cáo chi tiết về các bước kiểm thử, bằng chứng của lỗi (ảnh chụp màn hình, video, log file), và các yếu tố đã dẫn đến việc phát hiện lỗi.

- Công cụ trực quan hóa: Sử dụng các công cụ giúp trực quan hóa quá trình kiểm thử của AI, cho phép con người nhìn thấy những gì AI đang làm và hiểu được logic của nó.

- Kết hợp con người và AI: Con người và AI nên làm việc cùng nhau. AI làm những công việc nặng nhọc, lặp lại, trong khi con người phân tích và đưa ra quyết định cuối cùng dựa trên những dữ liệu do AI cung cấp.

Tóm lại, mặc dù "hộp đen AI" mang lại sự tiện lợi, nhưng nó cũng là một rủi ro AI không minh bạch tiềm ẩn. Để tránh những hậu quả nghiêm trọng, việc minh bạch hóa AI trong kiểm thử không chỉ là một lựa chọn mà là một yêu cầu bắt buộc, đảm bảo sự tin cậy và an toàn cho sản phẩm phần mềm.