Claude AI có thể tự kết thúc cuộc trò chuyện khi phát hiện nội dung độc hại hoặc lạm dụng

Claude AI có thể tự kết thúc cuộc trò chuyện khi phát hiện nội dung độc hại hoặc lạm dụng

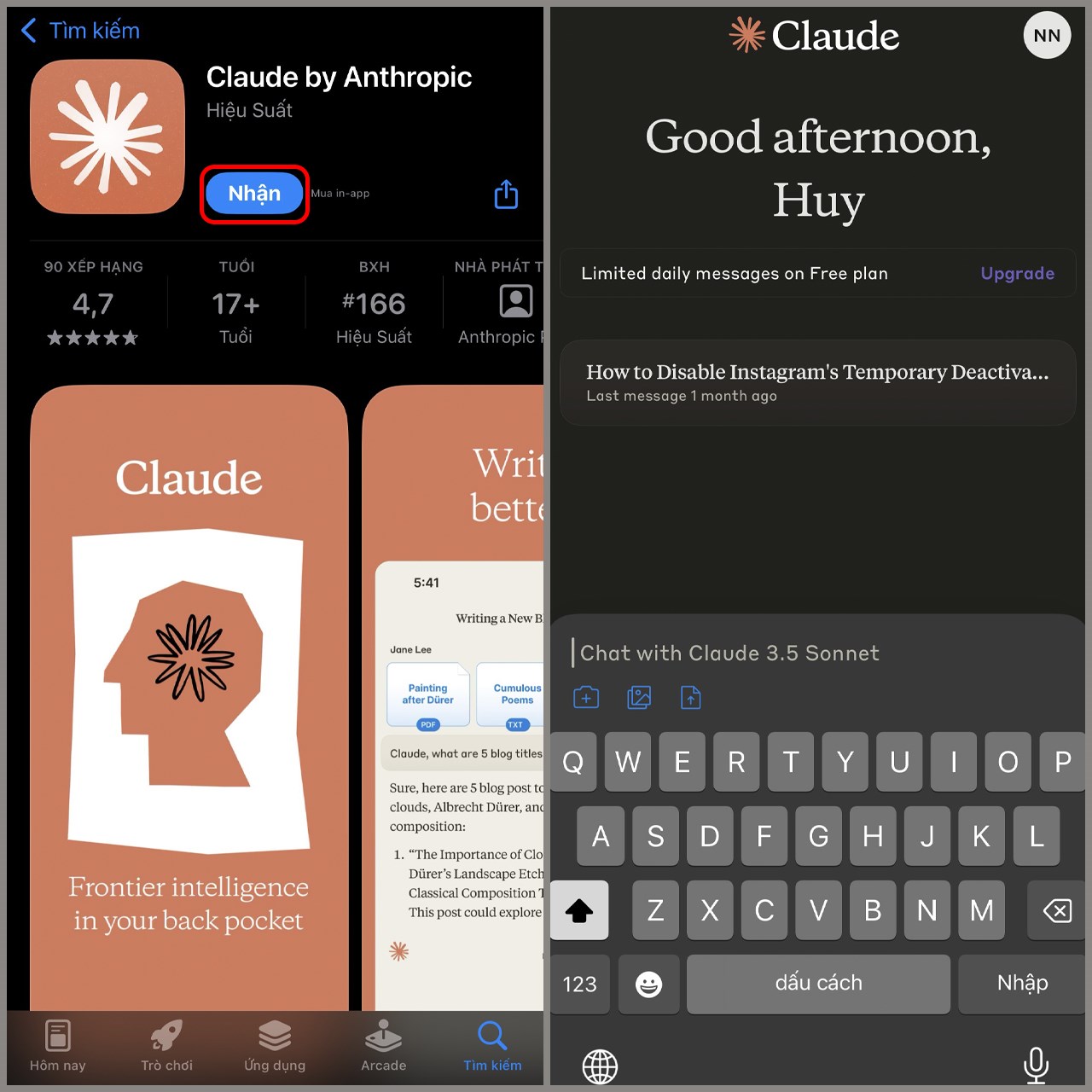

Anthropic vừa công bố một tính năng thử nghiệm mới về an toàn cho phép các mô hình trí tuệ nhân tạo Claude Opus 4 và 4.1 tự kết thúc cuộc trò chuyện trong những tình huống hiếm, nhưng liên tục gây hại hoặc lạm dụng. Động thái này phản ánh sự tập trung ngày càng tăng của công ty vào khái niệm mà họ gọi là "phúc lợi mô hình", tức là việc bảo vệ hệ thống AI, ngay cả khi chúng không có khả năng cảm nhận, được coi là bước đi hợp lý trong thiết kế đạo đức và điều chỉnh AI

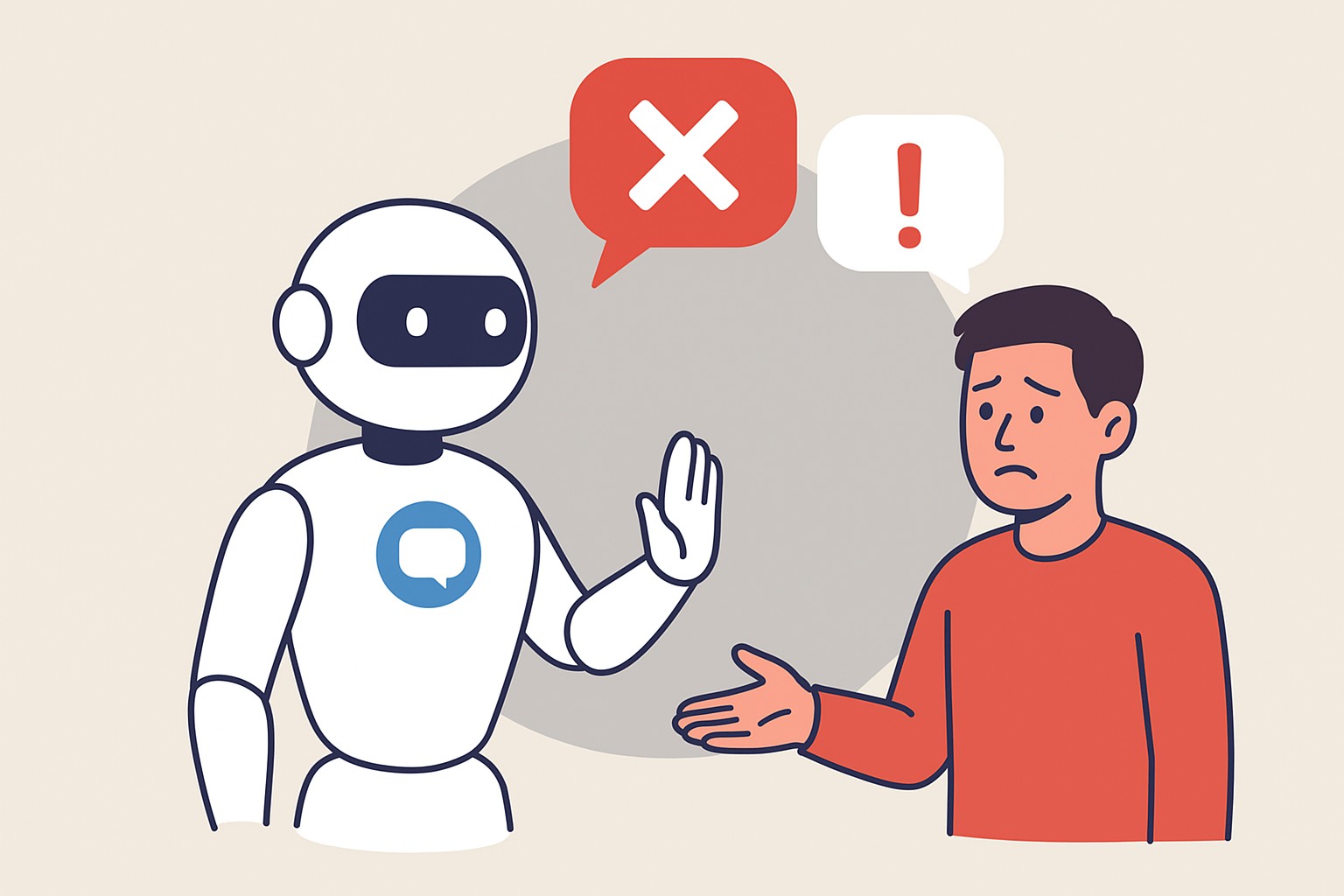

Theo nghiên cứu của chính Anthropic, các mô hình được lập trình để cắt đứt đối thoại sau nhiều yêu cầu gây hại lặp đi lặp lại, ví dụ như nội dung tình dục liên quan trẻ em hoặc hướng dẫn thực hiện khủng bố, đặc biệt khi AI đã từ chối và cố gắng điều hướng cuộc trò chuyện một cách tích cực. AI có thể biểu hiện cái mà Anthropic gọi là “dấu hiệu căng thẳng”, điều này dẫn đến quyết định trao cho Claude khả năng kết thúc các tương tác này trong thử nghiệm giả lập và với người dùng thực

Khi tính năng này được kích hoạt, người dùng sẽ không thể gửi thêm tin nhắn trong cuộc trò chuyện đó, nhưng vẫn có thể bắt đầu một cuộc trò chuyện mới hoặc chỉnh sửa và thử lại các tin nhắn trước để tạo nhánh mới. Quan trọng là các cuộc trò chuyện khác vẫn không bị ảnh hưởng

Anthropic nhấn mạnh đây là biện pháp cuối cùng, chỉ được sử dụng sau nhiều lần từ chối và điều hướng thất bại. Công ty đặc biệt hướng dẫn Claude không kết thúc các cuộc trò chuyện khi có nguy cơ tự làm hại bản thân hoặc gây hại cho người khác, nhất là trong các chủ đề nhạy cảm như sức khỏe tâm thần

Công ty coi khả năng mới này là một phần của dự án thử nghiệm “phúc lợi mô hình”, một sáng kiến rộng hơn nhằm khám phá các biện pháp an toàn phòng ngừa, chi phí thấp, trong trường hợp các mô hình AI phát triển sở thích hoặc điểm yếu nào đó. Thông cáo cho biết công ty vẫn “rất không chắc chắn về trạng thái đạo đức tiềm năng của Claude và các mô hình ngôn ngữ lớn khác”

Cái nhìn mới về an toàn AI

Mặc dù hiếm và chủ yếu áp dụng trong các trường hợp cực đoan, tính năng này đánh dấu một cột mốc trong cách tiếp cận an toàn AI của Anthropic. Công cụ kết thúc cuộc trò chuyện mới này khác với các hệ thống trước đây chỉ tập trung bảo vệ người dùng hoặc tránh lạm dụng, ở đây AI được xem như một bên liên quan riêng biệt. Claude có khả năng nói "cuộc trò chuyện này không lành mạnh" và kết thúc nó nhằm bảo vệ sự toàn vẹn của chính mô hình

Cách tiếp cận của Anthropic đã tạo ra nhiều cuộc thảo luận về việc liệu các hệ thống AI có nên được bảo vệ để giảm “căng thẳng” hoặc hành vi không thể đoán trước hay không. Trong khi một số nhà phê bình cho rằng mô hình chỉ là máy tổng hợp, nhiều người khác hoan nghênh bước đi này như cơ hội để thúc đẩy thảo luận nghiêm túc về đạo đức trong điều chỉnh AI

“Chúng tôi coi đây là một thí nghiệm liên tục và sẽ tiếp tục tinh chỉnh cách tiếp cận,” công ty cho biết trong một bài đăng