Chuyên gia tiết lộ những chiếc điện thoại AI mà người hâm mộ cần để đưa Gemini & ChatGPT đến giới hạn

Chuyên gia tiết lộ những chiếc điện thoại AI mà người hâm mộ cần để đưa Gemini & ChatGPT đến giới hạn

Micron / Xu hướng kỹ thuật số

Micron / Xu hướng kỹ thuật số

Một trong những xu hướng rõ ràng nhất — và thành thật mà nói, cũng là nhàm chán nhất — trong ngành công nghiệp điện thoại thông minh trong vài năm qua chính là những cuộc thảo luận không ngừng nghỉ về trải nghiệm AI. Đặc biệt, các chiến binh silicon thường quảng cáo bộ xử lý di động mới nhất của họ sẽ cho phép các quy trình AI trên thiết bị như tạo video.

Chúng ta đã ở đó rồi, mặc dù chưa hoàn toàn. Giữa những màn phô trương rầm rộ về các thủ thuật AI "thất bại" dành cho người dùng điện thoại thông minh , cuộc tranh luận hầu như không bao giờ vượt ra ngoài những bài thuyết trình hào nhoáng về bộ xử lý mới và các chatbot luôn phát triển.

Chỉ đến khi sự vắng mặt của Gemini Nano trên Google Pixel 8 gây xôn xao dư luận, công chúng mới nhận ra tầm quan trọng của dung lượng RAM đối với AI trên thiết bị di động. Ngay sau đó, Apple cũng tuyên bố rõ ràng rằng họ sẽ giới hạn Apple Intelligence trên các thiết bị có RAM ít nhất 8GB.

Nhưng hình ảnh "điện thoại AI" không chỉ xoay quanh dung lượng bộ nhớ. Khả năng thực hiện các tác vụ AI của điện thoại còn phụ thuộc vào khả năng tối ưu hóa RAM vô hình, cũng như các module lưu trữ. Và không, tôi không chỉ nói về dung lượng.

Những đổi mới về bộ nhớ hướng đến điện thoại AI

Micron / Xu hướng kỹ thuật số

Micron / Xu hướng kỹ thuật số

Digital Trends đã có buổi trò chuyện với Micron, công ty hàng đầu thế giới về giải pháp bộ nhớ và lưu trữ, để phân tích vai trò của RAM và bộ nhớ lưu trữ đối với các quy trình AI trên điện thoại thông minh. Những tiến bộ mà Micron mang lại chắc chắn sẽ nằm trong tầm ngắm của bạn khi bạn muốn mua một chiếc điện thoại cao cấp.

Sản phẩm mới nhất từ công ty có trụ sở tại Idaho bao gồm bộ nhớ di động G9 NAND UFS 4.1 và mô-đun RAM LPDDR5X 1γ (1-gamma) dành cho điện thoại thông minh hàng đầu. Vậy, chính xác thì các giải pháp bộ nhớ này thúc đẩy AI trên điện thoại thông minh như thế nào, ngoài việc tăng cường dung lượng?

Hãy bắt đầu với giải pháp lưu trữ G9 NAND UFS 4.1. Lời hứa hẹn bao trùm là tiết kiệm điện năng, độ trễ thấp hơn và băng thông cao . Chuẩn UFS 4.1 có thể đạt tốc độ đọc và ghi tuần tự tối đa 4100 MBps, tăng 15% so với thế hệ UFS 4.0, đồng thời cũng giảm thiểu độ trễ.

Có liên quan:

ChatGPT muốn chơi bác sĩ với chế độ đặc biệt, nhưng tôi sẽ bỏ qua

Một lợi ích quan trọng khác là các mô-đun lưu trữ di động thế hệ tiếp theo của Micron có dung lượng lên đến 2TB. Hơn nữa, Micron đã thu nhỏ kích thước của chúng, biến chúng thành giải pháp lý tưởng cho điện thoại màn hình gập và điện thoại mỏng thế hệ tiếp theo như Samsung Galaxy S25 Edge .

Micron / Xu hướng kỹ thuật số

Micron / Xu hướng kỹ thuật số

Chuyển sang tiến trình phát triển RAM, Micron đã phát triển mô-đun RAM 1γ LPDDR5X. Chúng đạt tốc độ tối đa 9200 MT/giây, có thể chứa nhiều hơn 30% số bóng bán dẫn nhờ kích thước được thu nhỏ và tiêu thụ điện năng thấp hơn 20%. Micron đã cung cấp giải pháp RAM 1β (1-beta) chậm hơn một chút, được tích hợp trong dòng điện thoại thông minh Samsung Galaxy S25 .

Sự tương tác giữa lưu trữ và AI

Ben Rivera, Giám đốc Tiếp thị Sản phẩm thuộc Bộ phận Kinh doanh Di động của Micron, cho biết Micron đã thực hiện bốn cải tiến quan trọng trên các giải pháp lưu trữ mới nhất của họ để đảm bảo hoạt động AI nhanh hơn trên thiết bị di động. Các cải tiến này bao gồm Zoned UFS, Data Defragmentation, Pinned WriteBooster và Intelligent Latency Tracker.

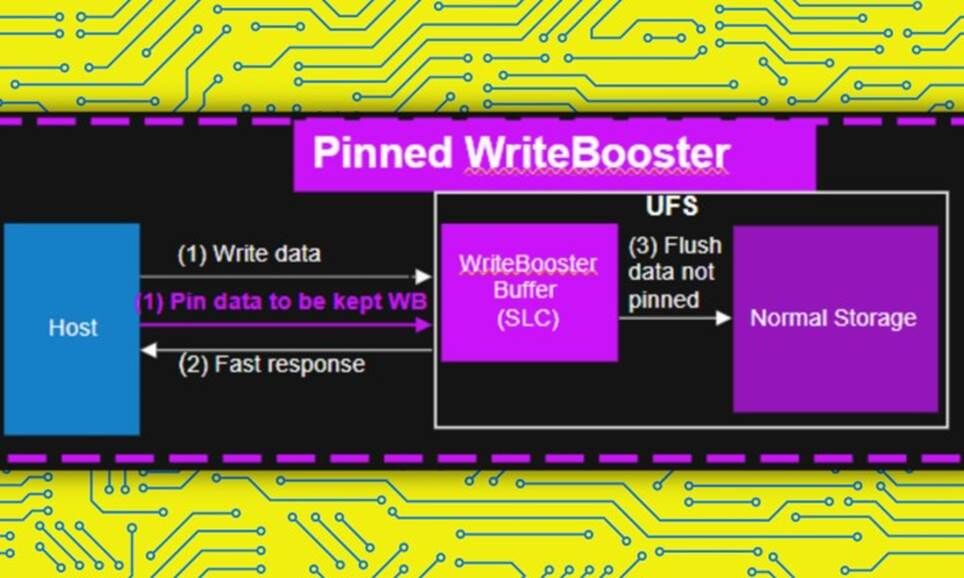

Rivera giải thích về tính năng Pinned WriteBooster: "Tính năng này cho phép bộ xử lý hoặc máy chủ xác định và cô lập hoặc "ghim" dữ liệu được sử dụng thường xuyên nhất của điện thoại thông minh vào một vùng của thiết bị lưu trữ được gọi là bộ đệm WriteBooster (tương tự như bộ nhớ đệm) để cho phép truy cập nhanh chóng".

Micron / Xu hướng kỹ thuật số

Micron / Xu hướng kỹ thuật số

Mỗi mô hình AI – ví dụ như Google Gemini hay ChatGPT – muốn thực hiện các tác vụ trên thiết bị đều cần một bộ tệp hướng dẫn riêng được lưu trữ cục bộ trên thiết bị di động. Ví dụ, Apple Intelligence cần 7GB dung lượng lưu trữ cho tất cả các tác vụ của nó.

Để thực hiện một tác vụ, bạn không thể phân bổ toàn bộ gói AI vào RAM, vì nó sẽ cần không gian để xử lý các tác vụ quan trọng khác như gọi điện hoặc tương tác với các ứng dụng quan trọng khác. Để giải quyết hạn chế trên mô-đun lưu trữ Micron, một bản đồ bộ nhớ được tạo ra để chỉ tải các trọng số AI cần thiết từ bộ nhớ vào RAM.

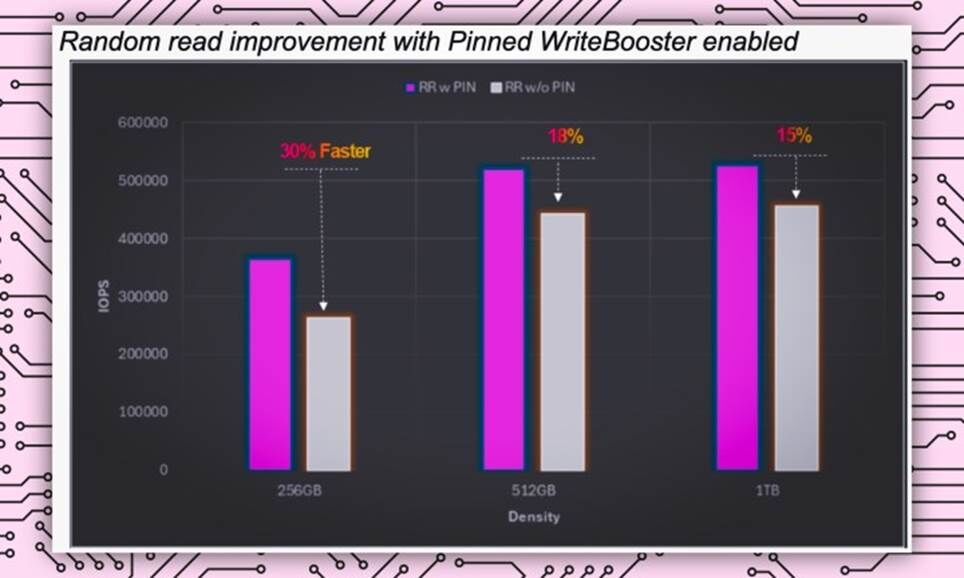

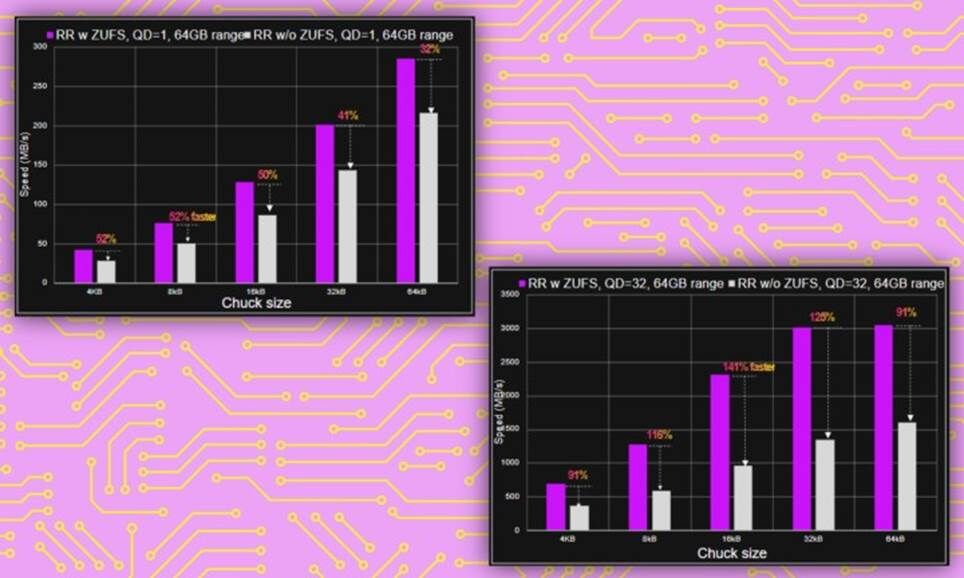

Khi tài nguyên bị hạn chế, điều bạn cần là trao đổi và đọc dữ liệu nhanh hơn. Điều này đảm bảo các tác vụ AI của bạn được thực thi mà không ảnh hưởng đến tốc độ của các tác vụ quan trọng khác. Nhờ Pinned WriteBooster, việc trao đổi dữ liệu này được tăng tốc lên 30%, đảm bảo các tác vụ AI được xử lý mà không bị chậm trễ.

Giả sử bạn cần Gemini kéo tệp PDF lên để phân tích . Việc hoán đổi bộ nhớ nhanh đảm bảo trọng số AI cần thiết được chuyển nhanh chóng từ bộ nhớ sang mô-đun RAM.

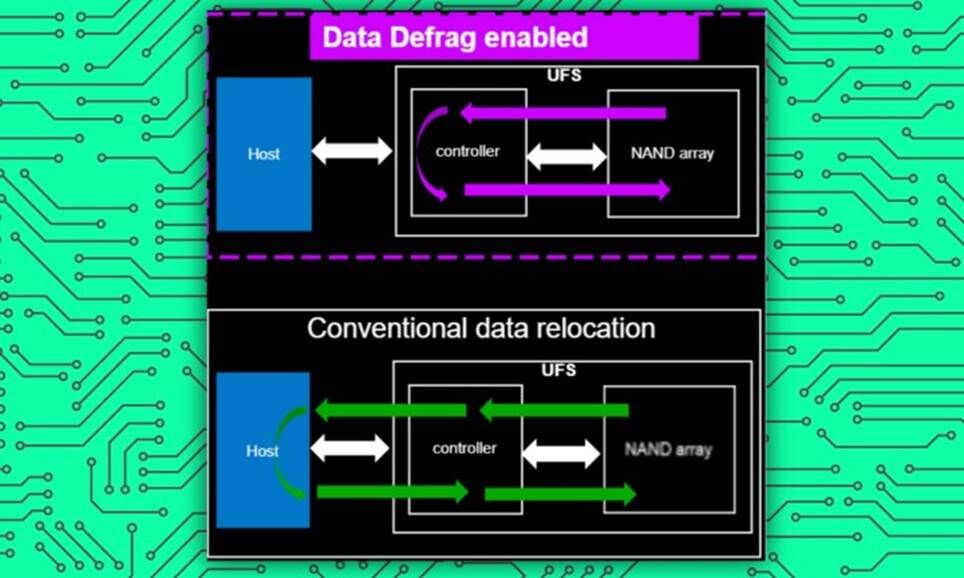

Tiếp theo, chúng ta có Data Defrag. Hãy tưởng tượng nó như một chiếc bàn làm việc hoặc tủ đựng đồ, đảm bảo các vật dụng được phân loại gọn gàng theo từng danh mục và được sắp xếp vào từng ngăn riêng biệt để dễ dàng tìm kiếm.

Micron / Xu hướng kỹ thuật số

Micron / Xu hướng kỹ thuật số

Trong bối cảnh điện thoại thông minh, khi dữ liệu được lưu trữ nhiều hơn trong thời gian sử dụng kéo dài, tất cả dữ liệu thường được lưu trữ một cách khá lộn xộn. Hậu quả là khi hệ thống tích hợp cần truy cập vào một loại tệp nhất định, việc tìm kiếm tất cả sẽ trở nên khó khăn hơn, dẫn đến hoạt động chậm hơn.

Theo Rivera, Data Defrag không chỉ giúp lưu trữ dữ liệu một cách có trật tự mà còn thay đổi lộ trình tương tác giữa bộ lưu trữ và bộ điều khiển thiết bị. Nhờ đó, tốc độ đọc dữ liệu được cải thiện đáng kể, lên đến 60% , giúp tăng tốc tất cả các loại tương tác giữa người dùng và máy móc, bao gồm cả quy trình làm việc của AI.

Giám đốc điều hành của Micron chia sẻ với Digital Trends: "Tính năng này có thể giúp đẩy nhanh các tính năng AI như khi một mô hình AI tạo sinh, như mô hình được sử dụng để tạo hình ảnh từ lời nhắc văn bản, được gọi từ bộ lưu trữ đến bộ nhớ, cho phép dữ liệu được đọc nhanh hơn từ bộ lưu trữ vào bộ nhớ".

Intelligence Latency Tracker là một tính năng khác về cơ bản giúp theo dõi các sự kiện trễ và các yếu tố có thể làm chậm tốc độ thông thường của điện thoại. Tính năng này sau đó hỗ trợ gỡ lỗi và tối ưu hóa hiệu suất điện thoại để đảm bảo các tác vụ thông thường cũng như AI không gặp phải tình trạng giật lag.

Micron / Xu hướng kỹ thuật số

Micron / Xu hướng kỹ thuật số

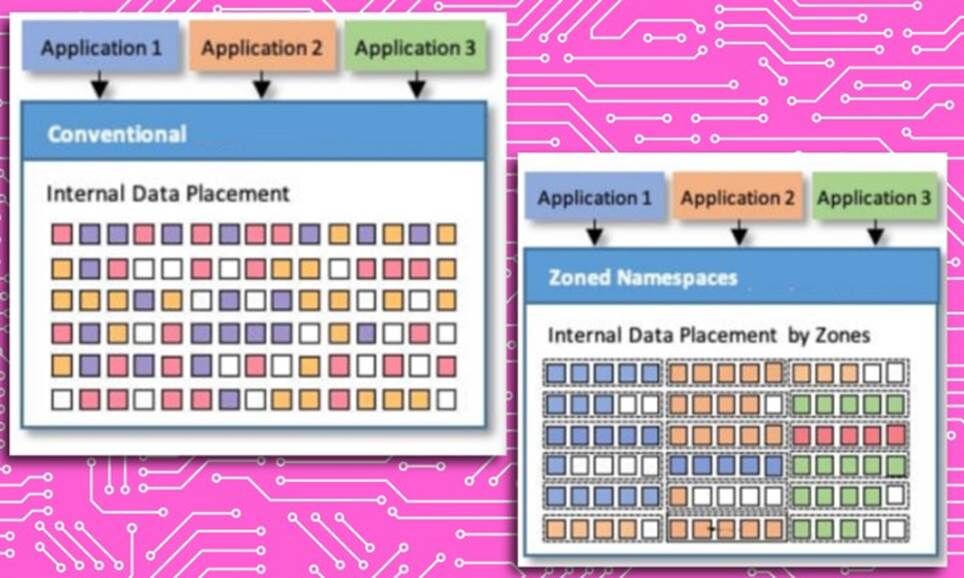

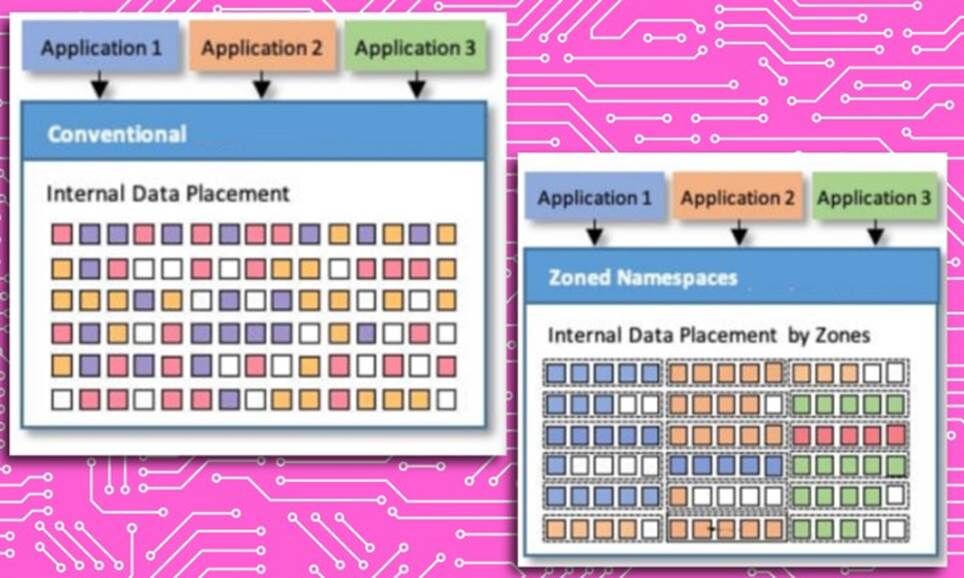

Cải tiến lưu trữ cuối cùng là UFS phân vùng. Hệ thống này đảm bảo dữ liệu có cùng đặc điểm I/O được lưu trữ một cách có trật tự. Điều này rất quan trọng vì nó giúp hệ thống dễ dàng định vị các tệp cần thiết, thay vì mất thời gian lục tung tất cả các thư mục và thư mục.

Rivera cho biết: "Tính năng ZUFS của Micron giúp sắp xếp dữ liệu để khi hệ thống cần xác định vị trí dữ liệu cụ thể cho một tác vụ, quá trình này sẽ diễn ra nhanh hơn và mượt mà hơn".

Vượt quá dung lượng RAM

Khi nói đến quy trình làm việc AI, bạn cần một lượng RAM nhất định. Càng nhiều càng tốt. Trong khi Apple đặt mức cơ sở là 8GB cho bộ công cụ Apple Intelligence, thì các đối thủ trong hệ sinh thái Android đã chuyển sang 12GB làm mặc định an toàn. Tại sao vậy?

“Các trải nghiệm AI cũng cực kỳ tốn dữ liệu và do đó rất tốn điện năng. Vì vậy, để hiện thực hóa lời hứa về AI, bộ nhớ và lưu trữ cần phải cung cấp độ trễ thấp và hiệu suất cao với hiệu suất năng lượng tối đa”, Rivera giải thích.

Với giải pháp RAM LPDDR5X 1γ (1-gamma) thế hệ tiếp theo dành cho điện thoại thông minh, Micron đã thành công trong việc giảm điện áp hoạt động của các mô-đun bộ nhớ. Vấn đề quan trọng tiếp theo là hiệu suất cục bộ. Rivera cho biết các mô-đun bộ nhớ mới có thể hoạt động ở tốc độ lên đến 9,6 gigabit mỗi giây, đảm bảo hiệu suất AI hàng đầu.

Micron / Xu hướng kỹ thuật số

Micron / Xu hướng kỹ thuật số

Micron cho biết những cải tiến trong quy trình quang khắc cực tím (EUV) đã mở ra cánh cửa không chỉ cho tốc độ cao hơn mà còn cho hiệu suất năng lượng tăng 20%.

Con đường dẫn đến trải nghiệm AI riêng tư hơn?

Các giải pháp RAM và lưu trữ thế hệ tiếp theo của Microns dành cho điện thoại thông minh không chỉ hướng đến việc cải thiện hiệu suất AI mà còn cải thiện tốc độ xử lý chung của các tác vụ hàng ngày trên điện thoại thông minh. Tôi tò mò liệu bộ nhớ di động G9 NAND UFS 4.1 và RAM LPDDR5X 1γ (1-gamma) có tăng tốc bộ xử lý AI ngoại tuyến hay không.

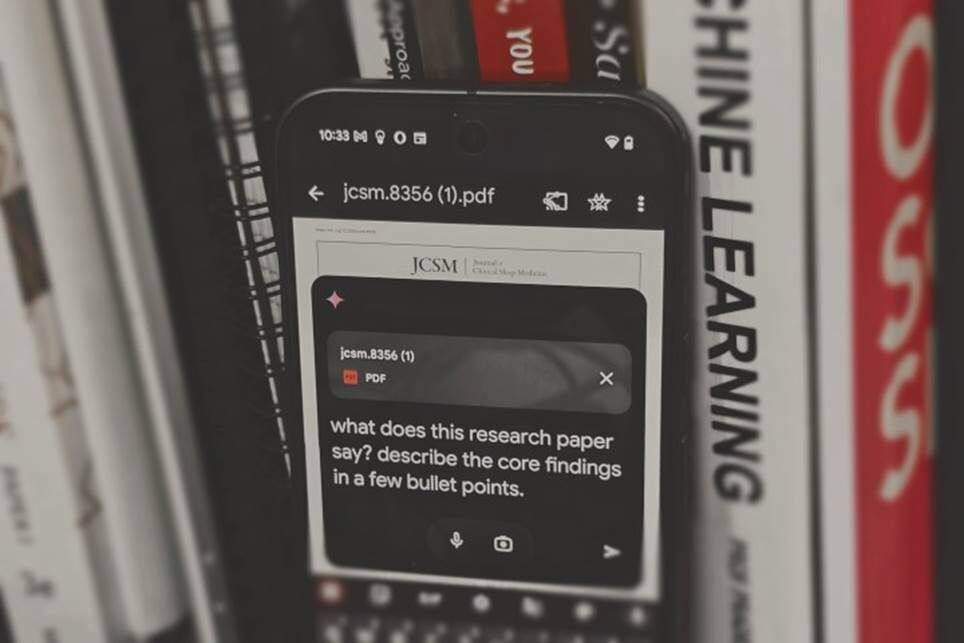

Các nhà sản xuất điện thoại thông minh cũng như các phòng thí nghiệm AI đang ngày càng chuyển sang xử lý AI cục bộ . Điều này có nghĩa là thay vì gửi truy vấn của bạn đến máy chủ đám mây nơi xử lý hoạt động, rồi kết quả được gửi đến điện thoại của bạn thông qua kết nối internet, toàn bộ quy trình làm việc sẽ được thực hiện cục bộ trên điện thoại của bạn.

Nadeem Sarwar / Xu hướng số

Nadeem Sarwar / Xu hướng số

Từ việc ghi âm cuộc gọi và ghi chú thoại đến việc xử lý tài liệu nghiên cứu phức tạp dưới dạng tệp PDF, mọi thứ đều diễn ra trên điện thoại và không có dữ liệu cá nhân nào bị mất khỏi thiết bị. Đây là một giải pháp an toàn hơn, nhanh hơn, nhưng đồng thời cũng đòi hỏi tài nguyên hệ thống mạnh mẽ. Một mô-đun bộ nhớ nhanh hơn và hiệu quả hơn là một trong những điều kiện tiên quyết đó.

Liệu các giải pháp thế hệ tiếp theo của Micron có thể hỗ trợ xử lý AI cục bộ không? Câu trả lời là có. Trên thực tế, nó cũng sẽ tăng tốc các quy trình yêu cầu kết nối đám mây, chẳng hạn như tạo video bằng mô hình Veo của Google , vốn vẫn cần máy chủ tính toán mạnh mẽ.

"Một ứng dụng AI gốc chạy trực tiếp trên thiết bị sẽ có lưu lượng dữ liệu lớn nhất vì nó không chỉ đọc dữ liệu người dùng từ thiết bị lưu trữ mà còn thực hiện suy luận AI trên thiết bị. Trong trường hợp này, các tính năng của chúng tôi sẽ giúp tối ưu hóa luồng dữ liệu cho cả hai", Rivera nói với tôi.

Vậy, khi nào thì bạn có thể mong đợi những chiếc điện thoại được trang bị giải pháp Micron mới nhất sẽ lên kệ? Rivera cho biết tất cả các nhà sản xuất điện thoại thông minh lớn sẽ áp dụng mô-đun RAM và lưu trữ thế hệ tiếp theo của Micron. Về việc ra mắt thị trường, "các mẫu flagship ra mắt vào cuối năm 2025 hoặc đầu năm 2026" nên nằm trong tầm ngắm mua sắm của bạn.