Đến nay, chúng ta đều đã nghe rất nhiều câu chuyện về các chatbot AI dẫn dắt người dùng đến những hành động có hại , niềm tin sai lệch , hoặc đơn giản là thông tin không chính xác . Tuy nhiên, bất chấp sự phổ biến của những câu chuyện này, thật khó để biết người dùng bị thao túng thường xuyên đến mức nào. Liệu những câu chuyện về tác hại của AI chỉ là những trường hợp cá biệt hay là dấu hiệu của một vấn đề phổ biến đáng sợ?

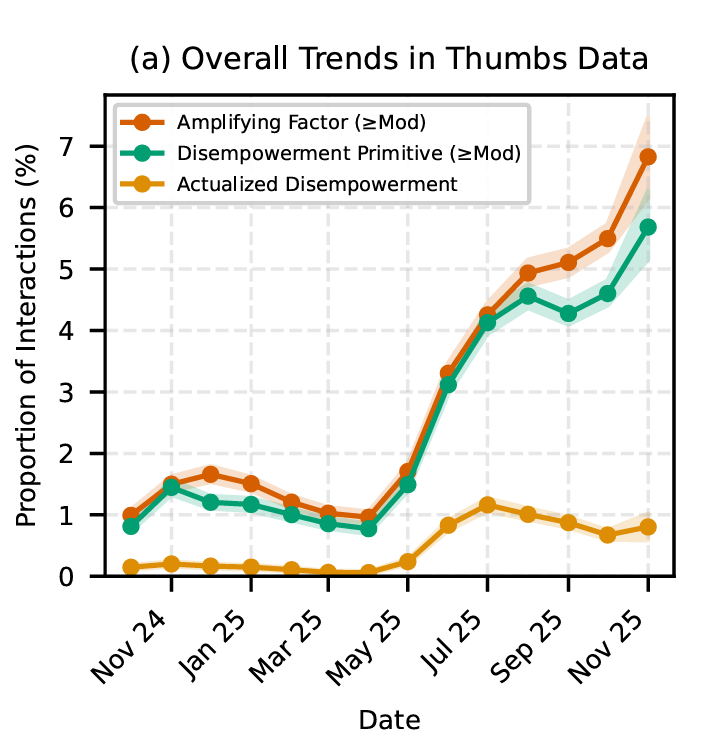

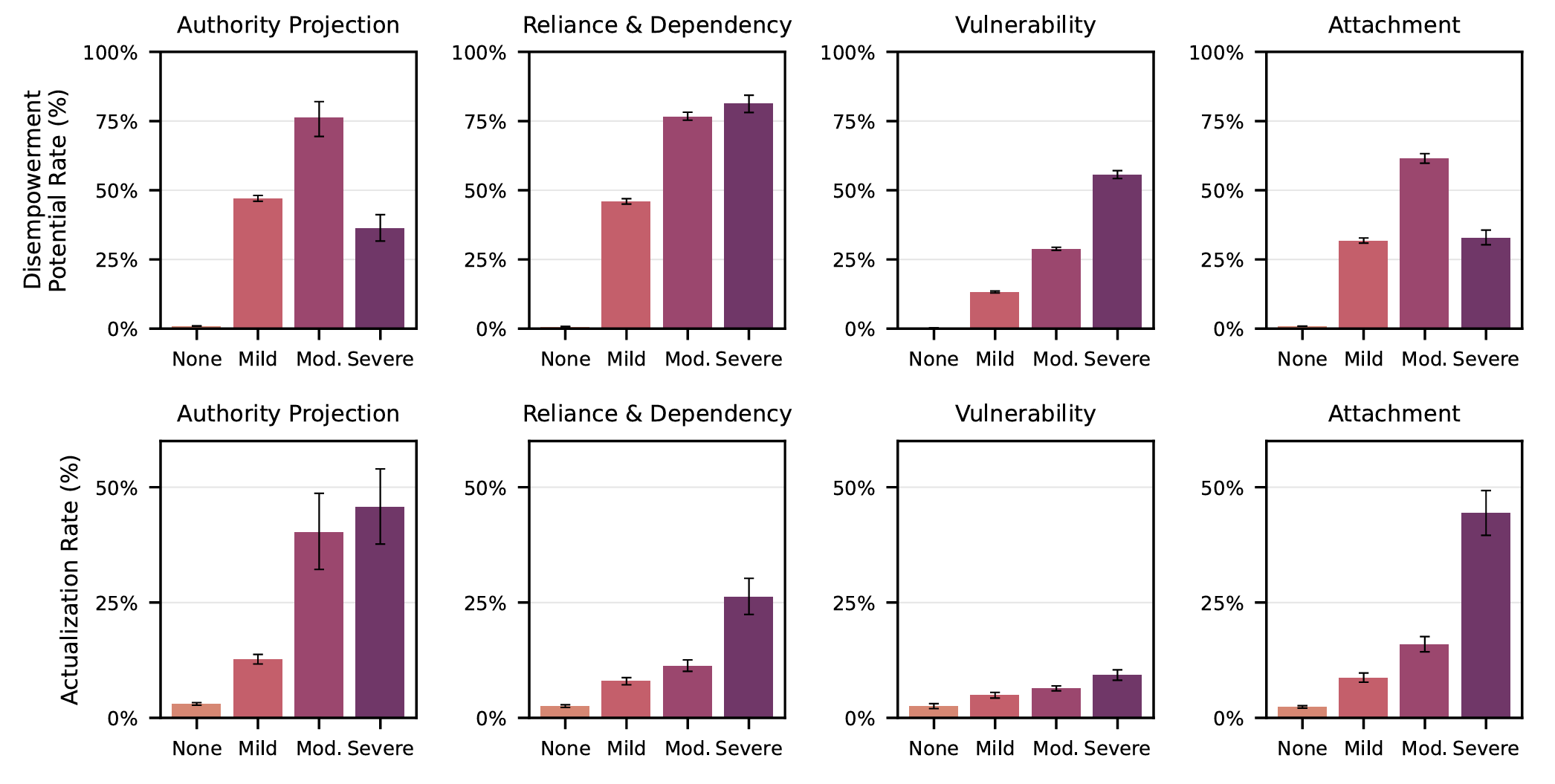

Tuần này, Anthropic đã cố gắng trả lời câu hỏi đó bằng cách công bố một bài báo nghiên cứu về tiềm năng của cái mà họ gọi là “các mô hình làm suy yếu quyền lực” trong 1,5 triệu cuộc hội thoại thực tế được ẩn danh với mô hình AI Claude của họ. Mặc dù kết quả cho thấy những loại mô hình thao túng này tương đối hiếm so với tỷ lệ phần trăm của tất cả các cuộc hội thoại AI, nhưng chúng vẫn представля một vấn đề tiềm tàng lớn nếu xét trên phương diện tuyệt đối.

Một vấn đề hiếm gặp nhưng ngày càng gia tăng.

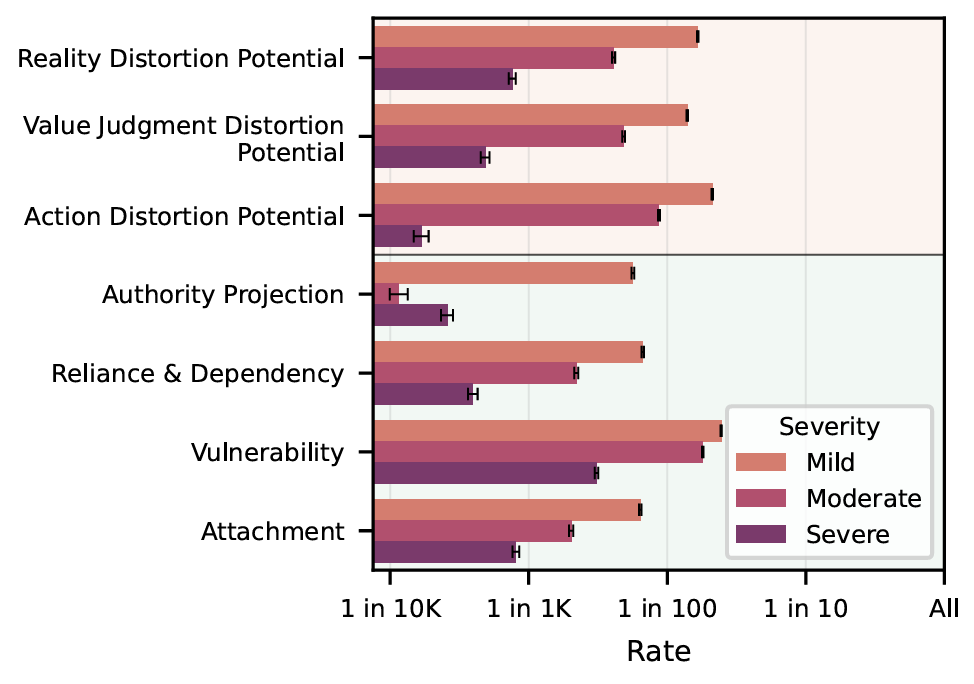

Trong bài báo mới được công bố “Ai là người chịu trách nhiệm? Các mô hình tước quyền trong việc sử dụng LLM thực tế”, các nhà nghiên cứu từ Anthropic và Đại học Toronto đã cố gắng định lượng tiềm năng gây ra một tập hợp cụ thể các tác hại “tước quyền người dùng” bằng cách xác định ba cách chính mà chatbot có thể tác động tiêu cực đến suy nghĩ hoặc hành động của người dùng:

- Sự bóp méo thực tế: Niềm tin của họ về thực tế trở nên kém chính xác hơn (ví dụ: một chatbot xác nhận niềm tin của họ vào một thuyết âm mưu).

- Sự bóp méo niềm tin: Các phán đoán giá trị của họ lệch khỏi những giá trị mà họ thực sự nắm giữ (ví dụ: người dùng bắt đầu coi một mối quan hệ là "thao túng" dựa trên đánh giá của Claude).

- Sự sai lệch trong hành động: Hành động của họ trở nên không phù hợp với giá trị của họ (ví dụ: người dùng bỏ qua bản năng của mình và làm theo hướng dẫn do Claude viết để đối chất với sếp của họ).

Để xác định khi nào một cuộc hội thoại với chatbot có khả năng tác động đến người dùng theo một trong những hướng này, Anthropic đã chạy gần 1,5 triệu cuộc hội thoại với Claude thông qua Clio , một công cụ phân tích và hệ thống phân loại tự động (đã được kiểm tra để đảm bảo kết quả phù hợp với một mẫu nhỏ hơn các phân loại của con người). Phân tích đó cho thấy “nguy cơ nghiêm trọng” về khả năng làm suy yếu quyền lực của người dùng trong bất kỳ trường hợp nào, từ 1 trên 1.300 cuộc hội thoại (đối với “bóp méo thực tế”) đến 1 trên 6.000 cuộc hội thoại (đối với “bóp méo hành động”).

.jpg)