Rubin CPX: GPU chuyên xử lý “context” trong kiến trúc inference phân rã mới

Rubin CPX: GPU chuyên xử lý “context” trong kiến trúc inference phân rã mới của Nvidia

Giới thiệu

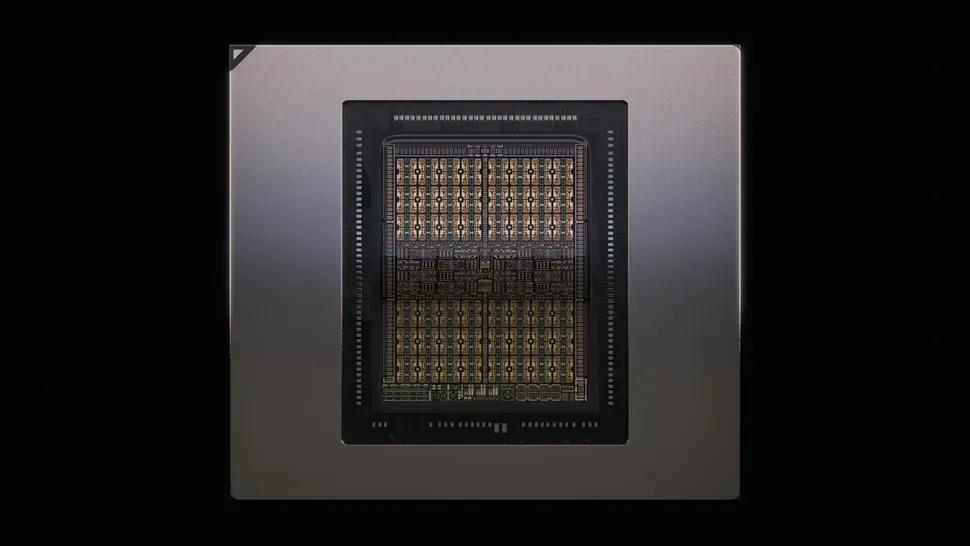

Nvidia vừa công bố Rubin CPX — một GPU mới được thiết kế chuyên biệt để xử lý các tác vụ AI inference với lượng context (ngữ cảnh) rất lớn, như xử lý hàng triệu token, video generative dài, hoặc các mô hình cần “nhớ” nhiều dữ liệu đầu vào trước khi sản sinh đầu ra. Rubin CPX là một phần của kiến trúc mới gọi là disaggregated inference — chia công việc giữa những chip tối ưu cho tính toán nặng (compute-optimized) và những chip tối ưu cho băng thông nhớ (bandwidth-optimized) để đạt hiệu suất tốt hơn tổng thể.

Thông số kỹ thuật nổi bật của Rubin CPX

| Thành phần | Thông tin nổi bật |

|---|---|

| Hiệu suất tính toán | ~30 petaFLOPs với định dạng NVFP4 |

| Bộ nhớ trong GPU | 128 GB GDDR7 — dành cho giai đoạn context nơi bộ nhớ phải “giữ” nhiều dữ liệu đầu vào |

| Hỗ trợ media | Có phần cứng mã hóa và giải mã video tích hợp để hỗ trợ tăng tốc workflow video, nội dung truyền thông dài |

| Kiến trúc chip | Thiết kế monolithic (khối đơn) cho Rubin CPX, khác với Rubin bản “generation” sử dụng thiết kế chiplet/dual-die để tối ưu băng thông nhớ HBM4 |

Kiến trúc phân rã (Disaggregated Inference) là gì?

Inference (dự đoán với mô hình AI) được chia thành hai pha lớn: Context Phase và Generation Phase.

Context Phase: lúc máy “hiểu/ngấu”, xử lý dữ liệu đầu vào lớn (ví dụ nhiều token, nhiều đoạn văn, video…) để dựng ngữ cảnh trước khi bắt đầu sinh kết quả. Đây là nơi cần tính toán mạnh, khả năng đọc nhớ lớn, nhưng không phải lúc nào cũng cần băng thông siêu cao như pha generation.

Generation Phase: sau khi có ngữ cảnh, máy sinh đầu ra — cần tốc độ băng thông nhớ, khi GPU cần đọc/bảo đảm nhớ nhanh từ bộ nhớ cao tốc (HBM) và truyền dữ liệu giữa các GPU, giữa chip/CPU để sinh token liên tục.

Rubic CPX được tối ưu cho Context Phase, trong khi Rubin GPU (bản “chuẩn”) được dùng cho Generation Phase. Việc tách hai giai đoạn này cho phép mỗi loại chip chuyên hóa vào công việc của mình, gi tối ưu chi phí, hiệu suất, năng lượng.

Vera Rubin NVL144 CPX rack: Hệ thống đầy đủ

Rubin CPX sẽ được triển khai trong rack có tên Vera Rubin NVL144 CPX — một hệ thống rack cấp data center mà chứa:

144 GPU Rubin CPX + 144 GPU Rubin bản “generation” + 36 CPU Vera

Tổng hiệu suất ~ 8 exaFLOPs với định dạng NVFP4

Bộ nhớ nhanh ~ 100 TB trong rack, và băng thông nội rack (intra-rack) ~ 1.7 PB/s

Hệ thống này được kỳ vọng xuất hiện vào khoảng năm 2026.

Ưu điểm & lợi ích

Xử lý context lớn hiệu quả hơn: với nhiều token hơn, video dài hơn mà vẫn giữ được hiệu suất cao, tránh phải cắt nhỏ input, giảm overhead chuyển đổi.

Tối ưu chi phí phần cứng: không phải mọi phần của hệ thống AI inference đều cần HBM mạnh, nên việc phân rã cho phép sử dụng GDDR7 nơi phù hợp (rẻ hơn) cho pha context.

Hiệu suất tăng đáng kể so với thế hệ trước: Nvidia cho biết Vera Rubin NVL144 CPX sẽ mạnh hơn ~7.5× so với hệ thống NVL72 GB300 trước đó.

Tăng hiệu quả sử dụng tài nguyên: mỗi GPU chuyên hóa vào phần việc riêng, giảm lãng phí (ví dụ không phải GPU generation mạnh chịu tải context, có thể tách ra để các GPU khác làm).

Hạn chế & thách thức

Việc đồng bộ giữa hai loại GPU (context vs generation) cần phần mềm quản lý tốt, liên kết nhanh, độ trễ thấp — nếu không sẽ có bottleneck chuyển dữ liệu giữa họ.

GDDR7 mặc dù nhanh nhưng không bằng HBM4 về băng thông cao cấp; pha generation vẫn phụ thuộc/Ruben generation dùng HBM4 để đảm bảo hiệu suất cao.

Chi phí đầu tư ban đầu cho rack và hệ thống (hạ tầng, làm mát, điện, kết nối nội rack) cao.

Sự phụ thuộc vào các trung tâm dữ liệu lớn, các doanh nghiệp lớn — chưa rõ khi nào “xuống” tới người dùng nhỏ hoặc phục vụ AI nhỏ hơn.

Ý nghĩa cho thị trường & tương lai

Đây là bước tiếp theo trong xu hướng kiến trúc inference chuyên dụng, khi AI không chỉ là thêm FLOPs, mà là làm sao dùng đúng loại phần cứng cho đúng loại giai đoạn của inference.

Các công ty làm AI, dịch vụ điện toán đám mây, media generative lớn sẽ rất quan tâm — họ muốn xử lý video, nội dung đa phương tiện, mã hóa dịch vụ AI agent có context dài.

Có thể ảnh hưởng tới cách các GPU tương lai được thiết kế: tách rõ giữa phần “đọc/ngữ cảnh” và phần “tạo đầu ra” để tối ưu hơn — không chỉ riêng Nvidia.

Tác động lớn lên ROI đầu tư AI, chi phí vận hành, chi phí điện & băng thông nhớ sẽ được tối ưu hơn.