Các nhà nghiên cứu từ Anthropic cho biết gần đây họ đã quan sát thấy “chiến dịch gián điệp mạng do AI dàn dựng được báo cáo lần đầu tiên ” sau khi phát hiện tin tặc nhà nước Trung Quốc sử dụng công cụ AI Claude của công ty trong một chiến dịch nhắm vào hàng chục mục tiêu. Các nhà nghiên cứu bên ngoài được đo lường nhiều hơn trong việc mô tả tầm quan trọng của khám phá.

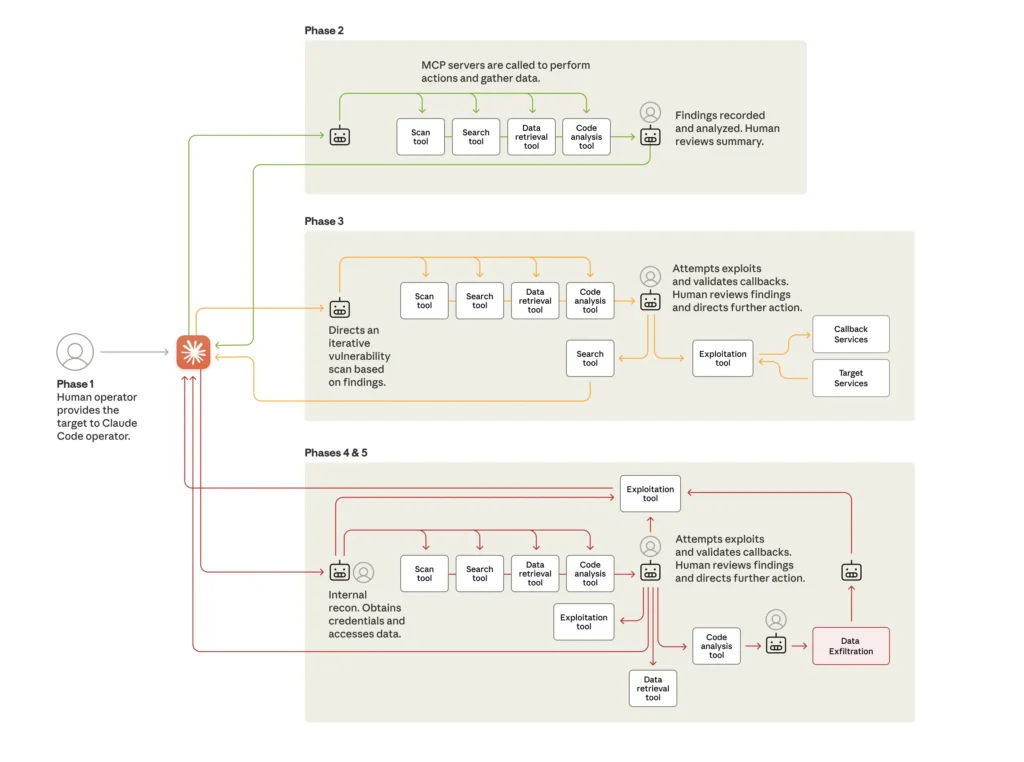

Anthropic đã công bố các báo cáo vào thứ Năm đây và đây. Vào tháng 9, các báo cáo cho biết, Anthropic đã phát hiện ra một chiến dịch gián điệp cực kỳ tinh vi,“do một nhóm do nhà nước Trung Quốc bảo trợ thực hiện và đã sử dụng Mã Claude để tự động hóa tới 90 phần trăm công việc. Sự can thiệp của con người chỉ được yêu cầu “lẻ tẻ (có lẽ 4-6 điểm quyết định quan trọng cho mỗi chiến dịch hack).” Anthropic cho biết tin tặc đã sử dụng khả năng tác nhân AI ở mức độ “chưa từng có.

“Chiến dịch này có ý nghĩa quan trọng đối với an ninh mạng trong thời đại AI ‘agents’—systems có thể chạy tự động trong thời gian dài và hoàn thành các nhiệm vụ phức tạp phần lớn không phụ thuộc vào sự can thiệp của con người,” Anthropic cho biết. “Đại lý có giá trị cho công việc hàng ngày và năng suất—nhưng trong tay kẻ xấu, chúng có thể làm tăng đáng kể khả năng tồn tại của các cuộc tấn công mạng quy mô lớn.”

“Hôn mông, ném đá và tạt axit”

Các nhà nghiên cứu bên ngoài đã không bị thuyết phục rằng phát hiện này là thời điểm bước ngoặt mà các bài đăng của Anthropic đã tạo ra. Họ đặt câu hỏi tại sao những loại tiến bộ này thường được cho là của tin tặc độc hại khi tin tặc mũ trắng và nhà phát triển phần mềm hợp pháp liên tục chỉ báo cáo lợi ích gia tăng từ việc sử dụng AI của họ.

“Tôi tiếp tục từ chối tin rằng những kẻ tấn công bằng cách nào đó có thể khiến những mô hình này vượt qua những vòng lặp mà không ai khác có thể làm được,” Dan Tentler, người sáng lập điều hành của Phobos Group và là nhà nghiên cứu có chuyên môn về các vi phạm bảo mật phức tạp, nói với Ars. “Tại sao các mô hình lại cung cấp cho những kẻ tấn công này những gì chúng muốn trong 90% thời gian nhưng những người còn lại trong chúng ta phải đối mặt với những vụ hôn mông, ném đá và tạt axit?”