Đến bây giờ, bạn có thể đã nghe nói về các cuộc gọi gian lận sử dụng AI để sao chép giọng nói của những người mà người nhận cuộc gọi biết. Thông thường, kết quả là những gì nghe giống như một đứa cháu, CEO hoặc đồng nghiệp làm việc mà bạn đã biết trong nhiều năm báo cáo một vấn đề khẩn cấp cần hành động ngay lập tức, nói rằng hãy chuyển tiền, tiết lộ thông tin đăng nhập hoặc truy cập một trang web độc hại.

Các nhà nghiên cứu và các quan chức chính ph đã được cảnh báo về mối đe dọa trong nhiều năm, với Cơ quan An ninh mạng và Cơ sở hạ tầng nói rằng vào năm 2023, các mối đe dọa từ deepfake và các dạng phương tiện tổng hợp khác đã tăng lên “theo cấp số nhân.” Năm ngoái, bộ phận bảo mật Mandiant của Google báo cáo rằng các cuộc tấn công như vậy đang được thực hiện với độ chính xác “kỳ lạ, tạo ra các kế hoạch lừa đảo thực tế hơn.”

Giải phẫu của một cuộc gọi lừa đảo deepfake

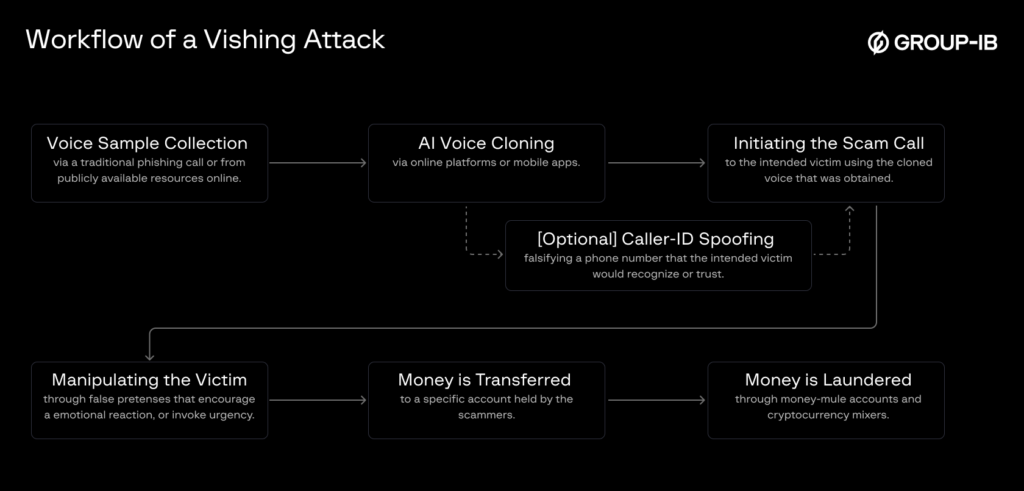

Vào thứ Tư, công ty bảo mật Group-IB phác thảo các bước cơ bản liên quan đến việc thực hiện các loại tấn công này. Điều rút ra là chúng dễ sinh sản ở quy mô lớn và có thể là thách thức để phát hiện hoặc đẩy lùi.

Thu thập mẫu giọng nói của người sẽ bị mạo danh. Các mẫu ngắn tới ba giây đôi khi là đủ. Chúng có thể đến từ video, cuộc họp trực tuyến hoặc cuộc gọi thoại trước đó.

Đưa mẫu vào công cụ tổng hợp giọng nói dựa trên AI, chẳng hạn như Tacotron 2 của Google, Vall-E của Microsoft hoặc các dịch vụ từ ElevenLabs và Resemble AI. Những công cụ này cho phép kẻ tấn công sử dụng giao diện chuyển văn bản thành giọng nói để tạo ra các từ do người dùng chọn với giọng nói và tiếng giật đàm thoại của người bị mạo danh. Hầu hết các dịch vụ đều cấm sử dụng deepfake như vậy, nhưng như Báo cáo người tiêu dùng tìm thấy trong tháng ba, các biện pháp bảo vệ mà các công ty này áp dụng để hạn chế hoạt động này có thể được bỏ qua với nỗ lực tối thiểu.

Một bước tùy chọn là giả mạo số thuộc về người hoặc tổ chức bị mạo danh. Những loại kỹ thuật này đã được sử dụng trong nhiều thập kỷ.

Tiếp theo, những kẻ tấn công bắt đầu cuộc gọi lừa đảo. Trong một số trường hợp, giọng nói nhân bản sẽ tuân theo một kịch bản. Trong các cuộc tấn công phức tạp hơn khác, lời nói giả mạo được tạo ra trong thời gian thực, sử dụng phần mềm chuyển đổi hoặc che giấu giọng nói. Các cuộc tấn công thời gian thực có thể thuyết phục hơn vì chúng cho phép kẻ tấn công trả lời các câu hỏi mà người nhận hoài nghi có thể hỏi.

“Mặc dù việc mạo danh theo thời gian thực đã được chứng minh bằng các dự án nguồn mở và API thương mại, nhưng việc đánh lừa deepfake trong tự nhiên theo thời gian thực vẫn còn hạn chế,” Group-IB cho biết. “Tuy nhiên, với những tiến bộ liên tục về tốc độ xử lý và hiệu quả của mô hình, việc sử dụng thời gian thực dự kiến sẽ trở nên phổ biến hơn trong tương lai gần.”