Nghiên cứu Chứng minh Tấn công Vishing Bằng Nhân bản Giọng nói AI Theo thời gian thực

Bài viết của TechNewsWorld, được công bố vào ngày 1 tháng 10 năm 2025, tiết lộ một nghiên cứu đột phá từ các nhà nghiên cứu an ninh mạng thuộc NCC Group. Nghiên cứu này chứng minh cách AI có thể được sử dụng để nhân bản giọng nói của một người theo thời gian thực nhằm thực hiện các cuộc tấn công lừa đảo qua điện thoại (vishing) tinh vi nhắm vào các tổ chức.

Các nhà nghiên cứu đã sử dụng thành công công nghệ này để tấn công các tổ chức có thật (trong một môi trường kiểm soát) và thu thập được thông tin nhạy cảm và bảo mật.

1. AI Nhân bản Giọng nói Trong Thời gian Thực

Điểm mấu chốt của nghiên cứu này là việc vượt qua các rào cản kỹ thuật của công nghệ deepfake trước đây:

Công nghệ Deepfake Truyền thống: Hầu hết các công nghệ deepfake giọng nói hiện đại đều tập trung vào việc suy luận ngoại tuyến (offline inference) và phụ thuộc vào mô hình Text-to-Speech (TTS). Chúng chỉ hiệu quả khi nhân bản giọng nói của một đoạn ghi âm có sẵn và không thể thay đổi giọng nói của người dùng theo thời gian thực—một yêu cầu quan trọng đối với các cuộc tấn công vishing tương tác.

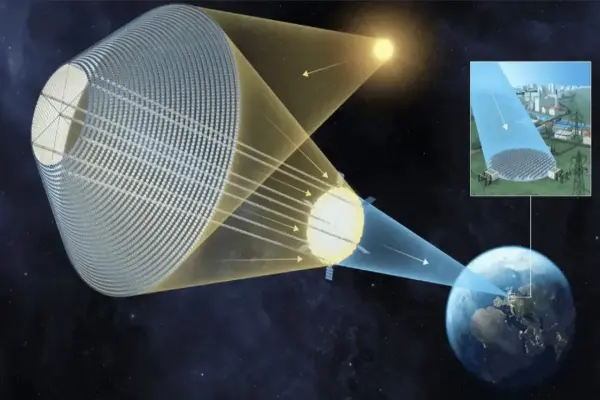

Giải pháp Mới: Các nhà nghiên cứu đã thiết lập một hệ thống định tuyến tín hiệu từ microphone của kẻ tấn công đến một bộ điều biến giọng nói theo thời gian thực (real-time voice modulator). Bộ điều biến này sử dụng mô hình học máy (ML) của giọng nói mục tiêu. Khi kẻ tấn công nói, nạn nhân sẽ nghe thấy giọng nói đã được nhân bản từ mô hình ML.

Tăng tính Thực tế: Công nghệ này làm cho trò lừa đảo trở nên đáng tin hơn, cho phép kẻ tấn công xử lý các câu hỏi bất ngờ, điều chỉnh yêu cầu và leo thang quyền hạn trong một cuộc trò chuyện trực tiếp, không bị gián đoạn.

2. Nguy cơ An ninh mạng và Tác động

Sự phát triển của AI nhân bản giọng nói theo thời gian thực được coi là một "lực lượng nhân rộng" (force multiplier) cho các cuộc tấn công lừa đảo xã hội (social engineering):

Tăng Khả năng Thành công: Các nạn nhân thường dựa vào số điện thoại người gọi, giọng nói và nội dung tin nhắn để đánh giá độ tin cậy. Giờ đây, tất cả những yếu tố này đều có thể bị làm giả hoặc nhân bản, làm tăng đáng kể khả năng thành công của cuộc tấn công.

Mục tiêu Rủi ro Cao: Kẻ tấn công có thể giả mạo các nhân vật có thẩm quyền cao như CEO, CFO hoặc nhân viên bộ phận CNTT để lừa đảo nhân viên tài chính chuyển tiền, đặt lại mật khẩu hoặc cung cấp thông tin đăng nhập đa yếu tố (MFA), gây ra tổn thất tài chính lớn.

Tấn công Đa kênh (Multi-channel): Mức độ nguy hiểm tăng lên khi công nghệ này được kết hợp với video deepfake theo thời gian thực trên các nền tảng hội nghị như Zoom hoặc Teams.

3. Biện pháp Phòng ngừa cho Tổ chức

Để giảm thiểu rủi ro từ các cuộc tấn công vishing do AI cung cấp, các tổ chức được khuyến cáo cần thực hiện các biện pháp sau:

Xác minh Thứ cấp: Thực hiện xác minh thứ cấp hoặc xác thực đa yếu tố (MFA) cho tất cả các yêu cầu nhạy cảm, ngay cả khi giọng nói nghe có vẻ quen thuộc.

Đào tạo Nhận thức: Đào tạo nhân viên để họ hoài nghi và cảnh giác với các yêu cầu bất thường, đặc biệt là những yêu cầu yêu cầu hành động gấp rút.

Hạn chế Dữ liệu công khai: Hạn chế việc công bố các bản ghi âm giọng nói của giám đốc điều hành và nhân viên cấp cao để giảm thiểu khả năng chúng bị sử dụng làm mẫu để tạo giọng nói tổng hợp.