Nvidia khẳng định H100 vượt MI300X khoảng 2× khi tối ưu đúng cách

Trong tuyên bố mới đây, Nvidia đáp trả các khẳng định của AMD về hiệu năng GPU MI300X, cho rằng nếu cấu hình và tối ưu phần mềm đúng cách, GPU H100 có thể đạt hiệu năng gấp đôi so với MI300X trong các tác vụ inference. Theo Nvidia, kết quả so sánh ban đầu do AMD công bố không sử dụng đầy đủ các tối ưu của TensorRT-LLM, vốn hỗ trợ những kernel được tinh chỉnh đặc biệt cho kiến trúc Hopper.

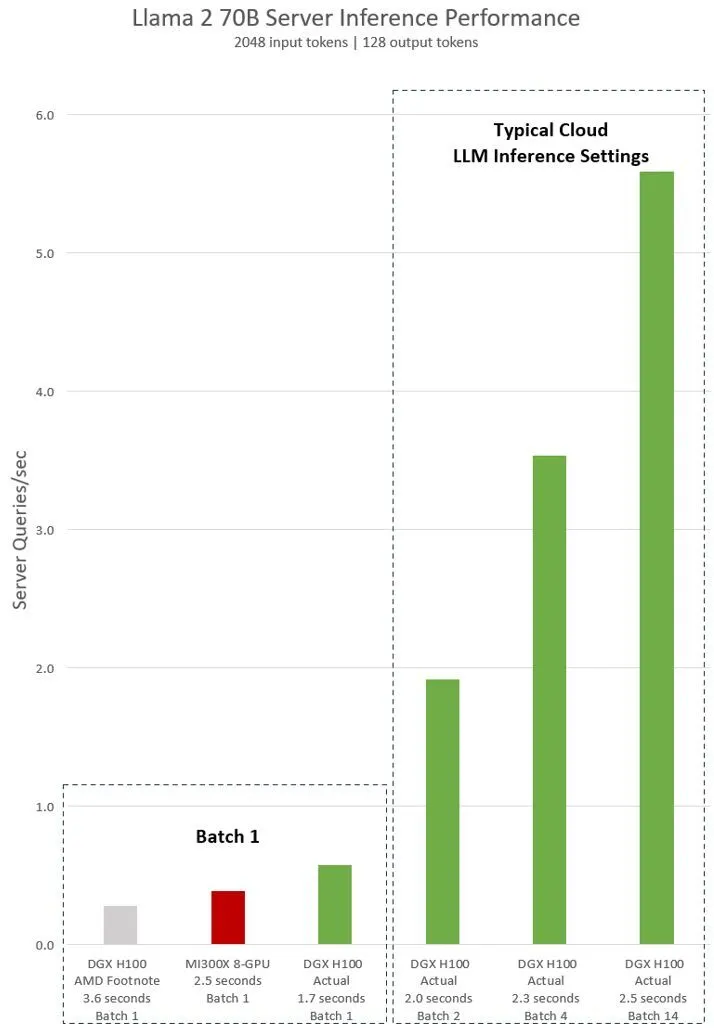

Cụ thể, Nvidia nhấn mạnh rằng trong thử nghiệm với mô hình Llama 2 70B, một hệ thống DGX H100 (8 GPU) chỉ mất khoảng 1,7 giây cho một phép inference đơn (batch size = 1), trong khi với MI300X 8 GPU, thời gian là 2,5 giây theo dữ liệu mà Nvidia trích dẫn từ AMD. Với cách đo “response time cố định” được nhiều dịch vụ cloud sử dụng — tức nếu thời gian đáp ứng được giữ ổn định, thiết bị có thể xử lý nhiều truy vấn hơn — Nvidia cho rằng hệ thống H100 sẽ xử lý được “hơn 5 inference mỗi giây” trong cấu hình 8 GPU, vượt trội so với MI300X trong cùng setup tương ứng.

Nvidia còn cho rằng các bản trình diễn của AMD không bao gồm các tối ưu kernel đặc thù cho kiến trúc Hopper, và việc sử dụng TensorRT-LLM là yếu tố then chốt để khai thác hiệu năng cao nhất của H100. Theo Nvidia, đây là lý do khiến hiệu suất thực tế của H100 trong các bài so sánh có thể bị “bóp” nếu không được tối ưu đúng cách.

Tuy nhiên, các nhận định này đều dựa vào dữ liệu do Nvidia công bố và so sánh theo cách họ chọn. Độc giả và giới chuyên môn vẫn lưu ý rằng hiệu năng cuối cùng còn phụ thuộc vào nhiều yếu tố: phần mềm, cách cấu hình, kích thước batch, mô hình AI sử dụng, và khả năng tối ưu từ AMD cũng như khả năng tối ưu của MI300X khi được test đúng cách.